Sommaire

- 1 Qu’est-ce que l’indexation de site web?

- 2 Quel rôle joue l’indexation de site web en SEO?

- 3 1. S’aider des différents outils pour corriger les erreurs d’indexation de site internet

- 4 2. Autoriser l’indexation de votre site web depuis votre Robots.txt.

- 5 3. Envoyer un sitemap de votre site web aux moteurs de recherche

- 6 4. Optimiser le maillage de vos (nouvelles) pages

- 7 5. Mettre à jour vos anciens contenus

- 8 6. Provoquer des signaux externes (backlinks et social)

- 9 Gardez un oeil sur vos Googlebots!

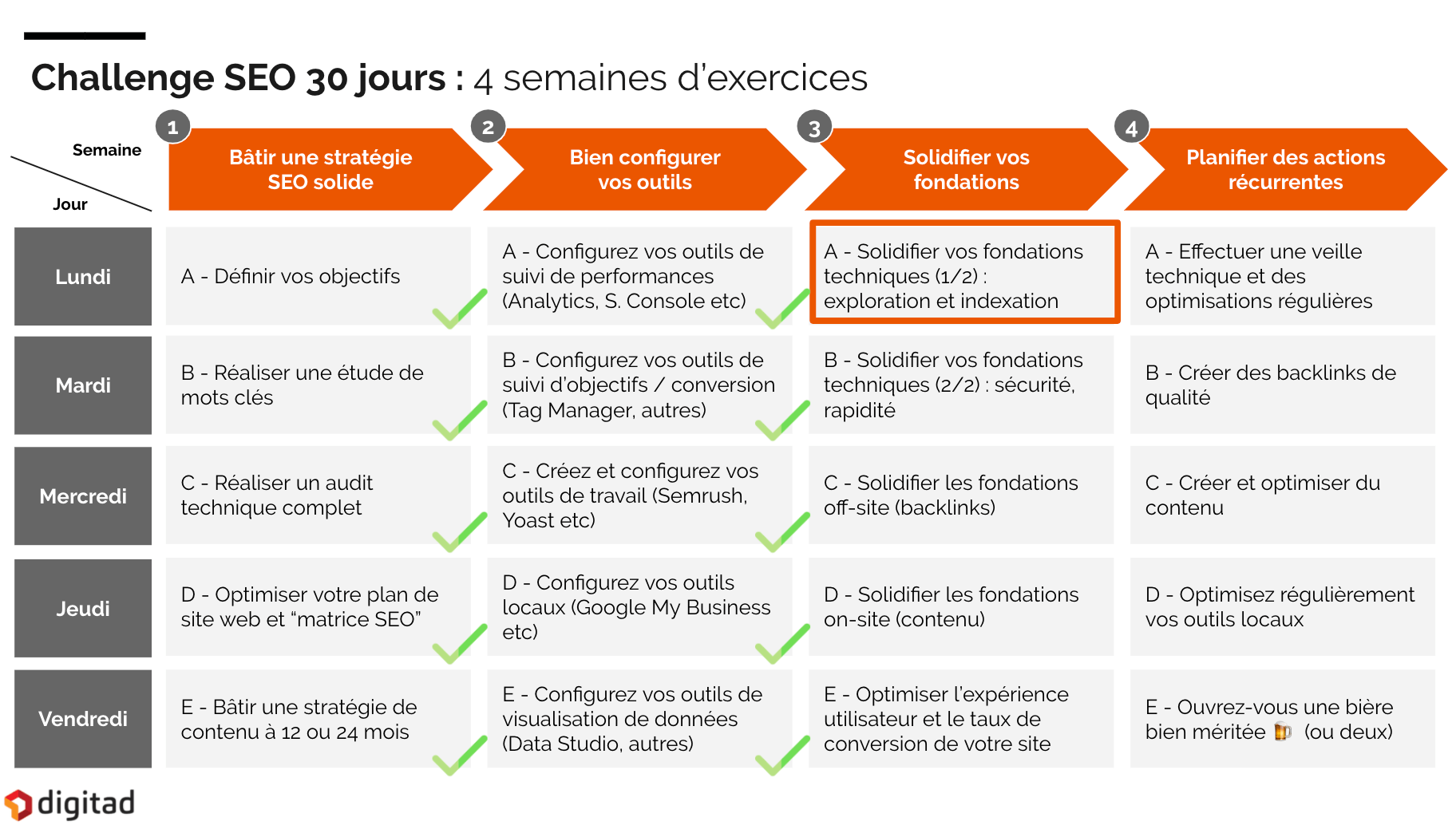

[Défi SEO – Jour 11]

Mais avant de fournir tous ces efforts dans le vide, vous êtes-vous déjà demandé si Google peut correctement accéder à vos contenus?

Après avoir posé les bases de votre stratégie SEO et configuré vos outils de travail, notre Agence SEO à Montréal aborde la troisième semaine du défi SEO 30 jours consacrée aux fondations de votre référencement naturel avec un exercice focalisé sur l’indexation de Google!

Dans cet article, nous couvrirons les questions suivantes :

- Qu’est-ce que l’indexation Google?

- Quel impact a l’indexation Google sur le SEO?

- Comment faciliter l’indexation Google de son site web?

Vous souhaitez être accompagné de nos experts pour indexer votre site web? Découvrez notre forfait référencement web.

Qu’est-ce que l’indexation de site web?

On dit qu’une page qu’elle est indexée par un moteur de recherche une fois que le robot d’exploration l’a répertoriée dans l’index de recherche Google. Lors de son exploration, le Googlebot analyse plusieurs facteurs techniques et détermine ensuite si le contenu analysé peut être affiché dans la recherche Google.

Quel rôle joue l’indexation de site web en SEO?

Afin d’améliorer les chances de voir votre contenu mis en avant sur les moteurs de recherche, vous devez faire en sorte d‘autoriser et de faciliter l’indexation de vos pages web par les moteurs de recherche comme Google et Bing. Le but de l’optimisation de l’indexation Google est d’aiguiller les Googlebots dans leur exploration afin de s’assurer que vos contenus sont bien compris, analysés et répertoriés par Google (idéalement, face aux bonnes requêtes).

Si l’indexation et l’exploration vos pages n’est pas pleinement accessible par Google, vos contenus pourraient simplement devenir invisibles sur les moteurs de recherche.

Alors, comment optimiser l’indexation Google et l’exploration des Googlebots?

1. S’aider des différents outils pour corriger les erreurs d’indexation de site internet

Plusieurs erreurs peuvent affecter l’indexation de vos pages web par les moteurs de recherche. On retrouve généralement des erreurs comme :

- les erreurs 404 (page brisée ou supprimée)

- les erreurs 5xx (erreur serveur)

Ces erreurs représentent des signaux négatif pour les moteurs de recherche car elles freinent l’exploration de votre contenu par les Googlebots. Voici comment vous pouvez repérer et supprimer ces différentes erreurs :

1. Suivez les recommandations de la Google Search Console

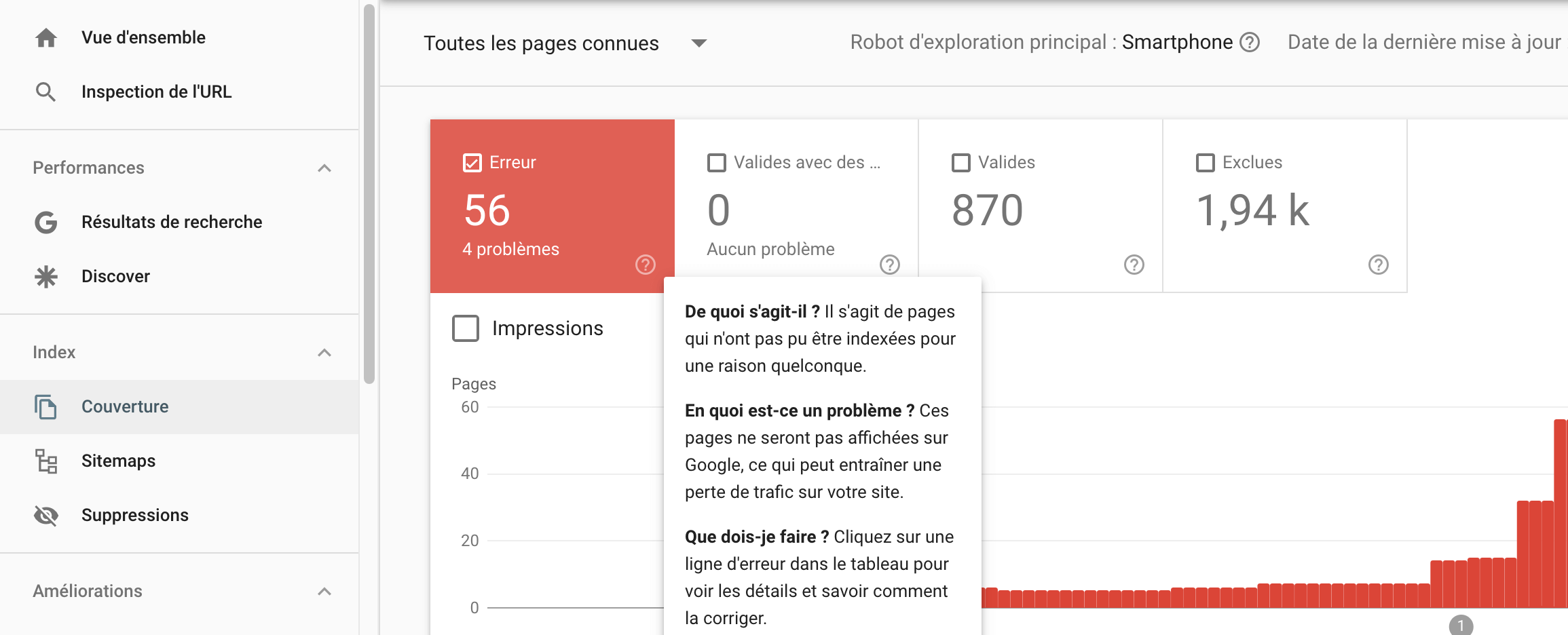

Lorsque que vous vous connectez dans votre Google Search Console, vous avez accès à un menu “Couverture” qui vous indiquera les différentes erreurs d’indexation présentes sur votre site web. Si votre site présente des erreurs, vous verrez apparaître ce type de rapport :

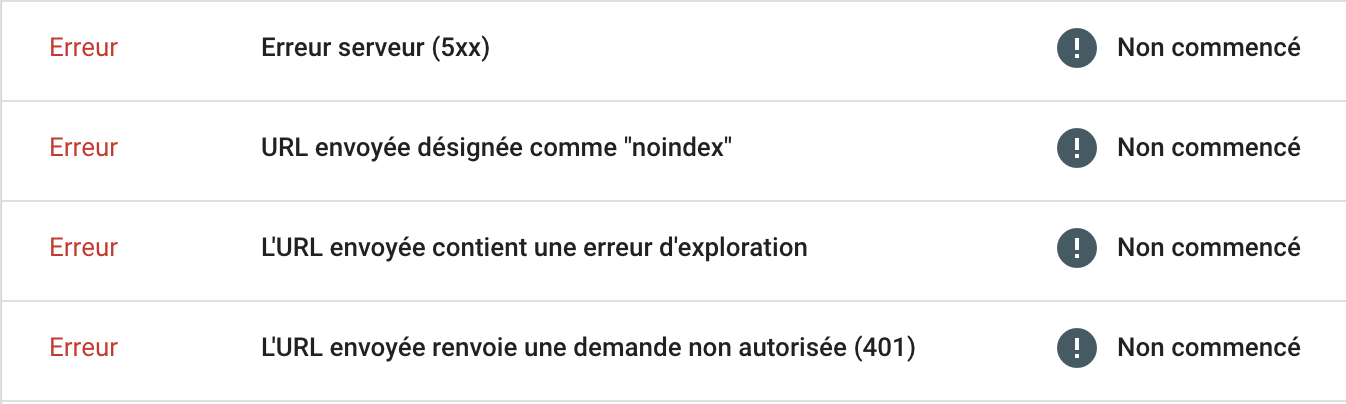

Dans la suite du rapport, Google vous indiquera ensuite les types d’erreurs qu’il a repérées.

Ces erreurs peuvent avoir plusieurs causes. En voici quelques exemples :

- Il existe sur votre site des liens ou des boutons vers des URL inexistantes.

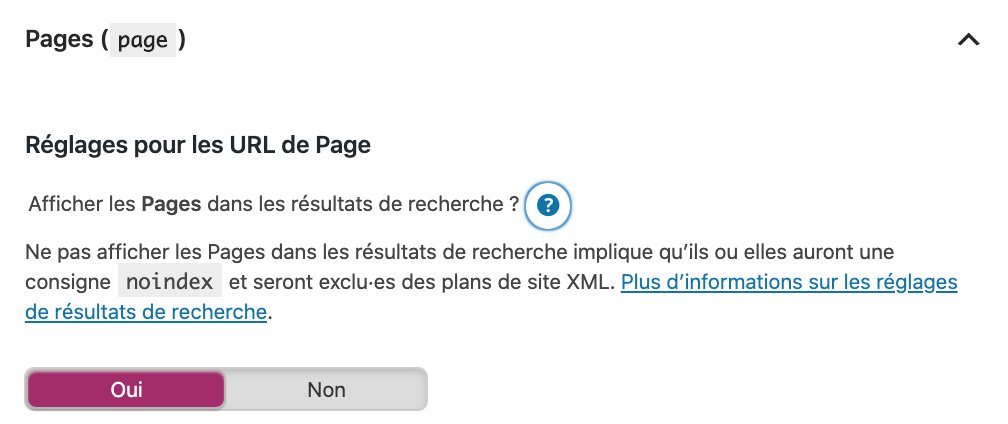

- Certaines pages sont en “NoIndex” ; Google a la consigne de ne pas les indexer.

- La configuration de votre serveur empêchent Google d’indexer vos pages

- Votre site web n’est pas correctement optimisé pour les mobiles

La plupart de ces erreurs peuvent être corrigées depuis votre système de gestion de contenu (comme WordPress). Certaines, comme les erreurs serveur ou les erreurs d’indexation mobile, peuvent nécessiter l’intervention de votre développeur web.

Si vous utilisez Yoast SEO dans WordPress, le menu “Réglage SEO” vous permet d’effectuer les premières actions correctives :

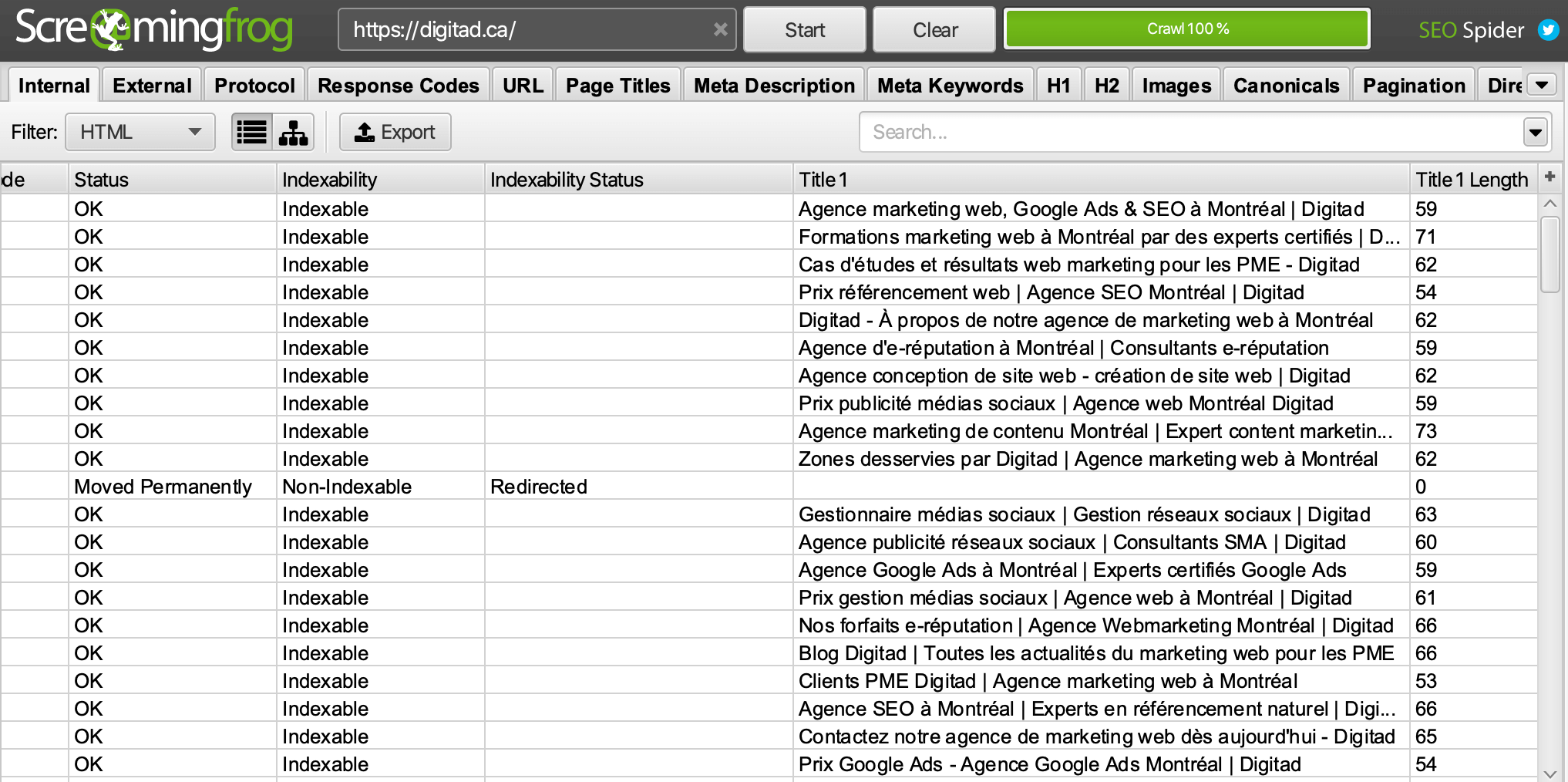

2. Utilisez un “Crawler” comme Screaming Frog

En complément des recommandations de la Google Search Console, vous pouvez utiliser un outil SEO de “Crawling” comme Screaming Frog.

Téléchargez et utilisez Screaming Frog (gratuit jusqu’à 500 URL), pour extraire la liste de tous les contenus de votre site web.

Entrez l’URL complet de votre site web et appuyez sur Start :

Pour y voir plus clair une fois le crawling terminé, sélectionnez le filtre “HTML“.

Vous disposerez d’une liste complète de toutes vos pages web, incluant leurs différents éléments de contenu ainsi qu’un rapport sur l’état de l’indexation de vos pages. Cela vous indiquera quelles pages nécessitent une modification ou une nouvelle redirection.

Pour comprendre les différents types de redirections de ce rapport d’indexation, n’hésitez pas à vous aider de ce guide des redirections 301.

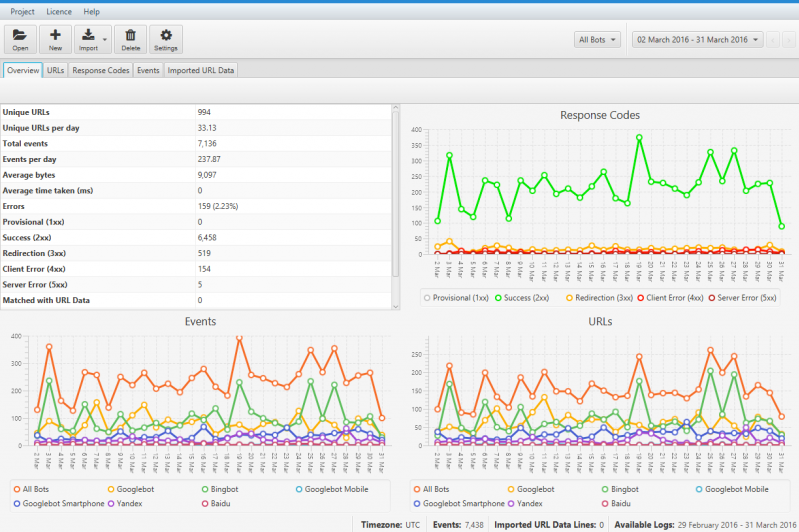

3. Faites une analyse de Logs

Cette analyse complémentaire à la Search Console et au crawling vous offre des données sur la façon dont votre site web est indexé par les différents moteurs de recherche.

Ce fichier se trouve sur votre serveur mais vous pouvez y accéder plus simplement en utilisant le Log File Analyzer de Screaming Frog.

Si votre site web présente des problèmes d’indexation pour un moteur de recherche, cette analyse vous permettra de les identifier et de remonter jusqu’à leur source. Cette source est d’ailleurs souvent votre Robots.txt. On y arrive justement!

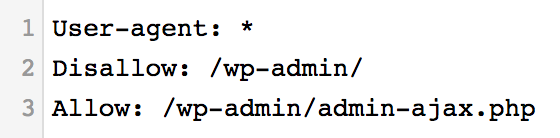

2. Autoriser l’indexation de votre site web depuis votre Robots.txt.

Pour vérifier si cette étape vous concerne, entrez le nom de domaine de votre site web suivi de /robots.txt dans votre navigateur.

Si vous voyez apparaître ce message, l’indexation est autorisée sur tout votre site web:

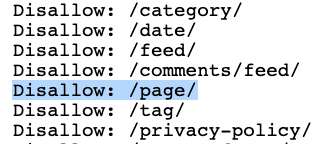

En revanche, si vous voyez apparaître une liste comme la suivante, cela signifie que chaque catégorie d’éléments à droite du “Disallow” ne sera pas indexée par Google :

Dans cet exemple, vos pages web normales ne seraient pas indexées par Google.

Mais notez qu’il n’est pas “grave” de voir apparaître certains éléments après un Disallow: dans votre robots.txt.

Par exemple, certains sites avec des dizaines de milliers de pages décident parfois de ne pas faire indexer certains contenus afin de concentrer l’exploration des Googlebots sur leurs pages les plus importantes.

En effet, sur les gros sites, les Googlebots ne vont pas parcourir l’intégralité du contenu en continu. Ils vont plutôt procéder par salves d’exploration sur un certain nombre de pages à la fois. Ce concept réfère au “Crawl budget” en anglais.

Si vous utilisez WordPress, ce guide de Yoast SEO vous aidera à ajuster votre robots.txt.

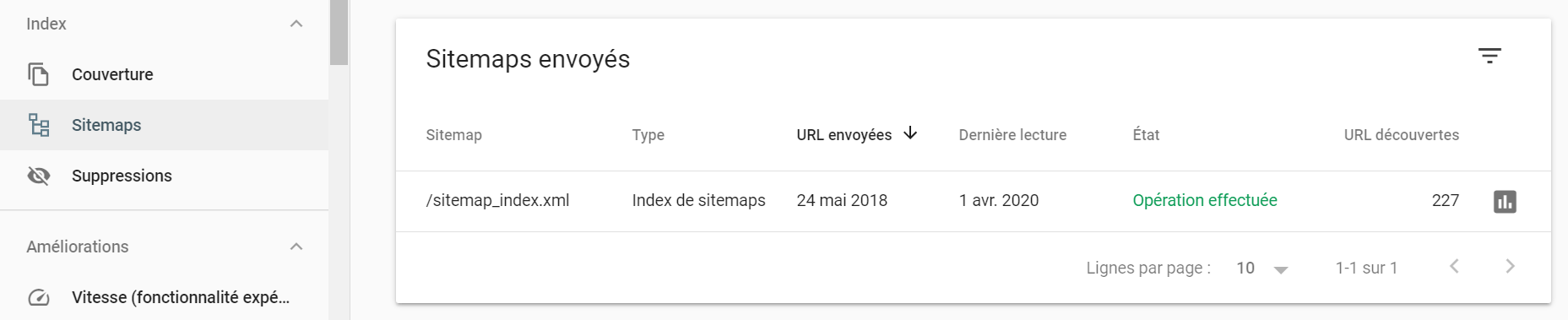

3. Envoyer un sitemap de votre site web aux moteurs de recherche

Imaginez atterrir seul(e) sur une île inconnue avec une mission: la parcourir en intégralité et répertorier toutes les ressources que vous y trouverez.

Vous iriez bien plus vite si on vous donnait une carte de cette île, n’est-ce pas?

Cette carte, pour les Googlebots, c’est votre sitemap.

Les sitemaps sont un des moyens les plus rapides pour indexer votre contenu sur Google.

Ce plan est automatiquement généré si vous utilisez le plugin Yoast. Autrement, vous pouvez utiliser XML Sitemap. Vous pouvez également envoyer un sitemap directement à Google depuis le rapport Sitemap de la Search Console.

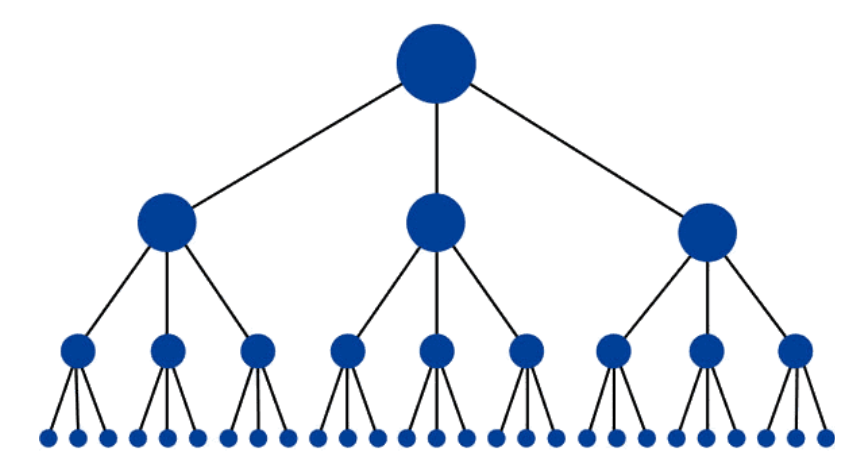

4. Optimiser le maillage de vos (nouvelles) pages

Essayez une nouvelle fois d’imaginer votre site web comme une carte. Chaque page est un point, et chaque lien de maillage interne SEO entre vos pages est un chemin pour se rendre à ce point. Si certaines de vos pages (souvent, les nouvelles) ne possèdent aucun lien entrant, les Googlebots auront plus de peine à les explorer et donc à les indexer.

On appelle ces pages des pages orphelines.

Vous pouvez repérer ces pages depuis votre rapport Screaming Frog en suivant ce guide.

Si une page n’a pas vocation à être indexée par Google (si vous avez une meilleure version de ce contenu par exemple) et qu’y ajouter un lien entrant n’est pas pertinent, vous pouvez toujours la rediriger vers la bonne page ou la placer en NoIndex.

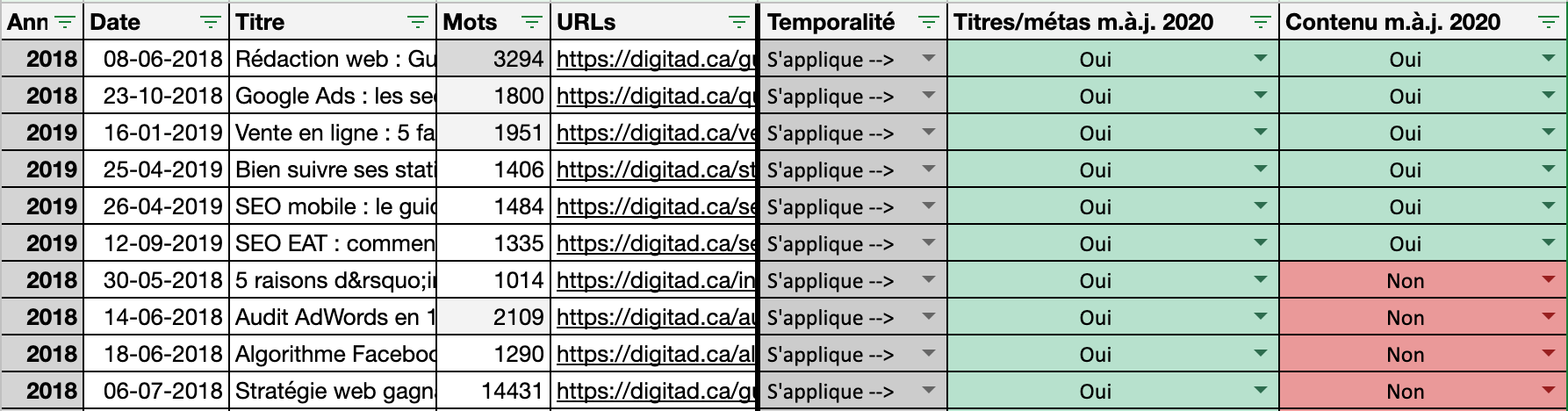

5. Mettre à jour vos anciens contenus

Google aime les contenus frais. Par frais, comprenez mis à jour ou récents. La mise à jour régulière de vos contenus permet aux Googlebots de comprendre que votre contenu est maintenu à jour et susceptible de bien vieillir. Cela les incitera à revenir “crawler” vos pages plusieurs fois. Un bon moyen d’obtenir la tant convoitée première position Google!

Ce conseil s’insère plus directement dans le domaine de l’optimisation de contenu que dans l’optimisation de l’indexation Google, mais l’impact des mise à jour sur l’exploration et l’indexation Google nous pousse toute de même à mentionner cette pratique.

Voici un exemple de fichier que vous pouvez créer pour garder à jour la temporalité de vos articles et pages web importantes (nous le faisons au moins une fois par an!) :

6. Provoquer des signaux externes (backlinks et social)

Pour arriver sur votre site web pour la première fois, Google peut avoir besoin d’un peu d’aide extérieure. Si aucune source externe (un autre site web un réseau social par exemple) ne dirige vers votre site web, Google pourrait alors prendre beaucoup de temps à accéder par lui-même à vos contenus pour les indexer.

Au contraire, chaque lien externe menant à votre site web sera une porte d’entrée supplémentaire pour vos utilisateurs, Googlebots compris.

Si vous possédez un tout nouveau site web sans backlinks, nous vous conseillons de l’inscrire sans attendre dans les annuaires d’entreprises de votre région et de votre industrie afin de profiter d’une première source de trafic web externe. Il en va de même pour vos différents réseaux sociaux.

Même si l’industrie du SEO (Google y compris) peine à trancher sur le degré de l’impact des social signals, partager vos contenus sur les médias sociaux ne pourra qu’ajouter une stimulation supplémentaire à l’indexation Google.

Gardez un oeil sur vos Googlebots!

Ces différents conseils devraient vous permettre de faire un bon pas vers l’appréciation de votre site web par les Googlebots. Mais ne vous relâchez pas! Il est impératif de vérifier régulièrement l’état de vos pages et de répéter le processus. Les bogues se déclarent souvent de façon inattendue et vous ne voulez pas les laisser affecter votre référencement naturel trop longtemps.

Dans le prochain article du défi SEO 30 jours, notre Agence d’audit SEO se penche sur un autre aspect technique important de votre référencement naturel : l’optimisation de la vitesse et de la sécurité de votre site web!

Autres ressources utiles

- En savoir plus sur les Core Web Vitals

- Découvrez un exemple de stratégie SEO